IA en Chile: modernización sin diagnóstico

- IA

- Políticas Públicas

- Ética

- Chile

En 2017, el paper Attention Is All You Need presentó la arquitectura Transformer, una pieza clave en modelos como ChatGPT o Gemini y de muchos sistemas actuales de IA. Desde entonces, una avalancha de soluciones “inteligentes” han empezado a redefinir procesos, negocios, e incluso la forma en que los gobiernos diseñan y ejecutan políticas públicas.

El problema es que, cuando no entendemos los problemas de fondo ni qué hacen realmente estas herramientas, esa promesa de modernización termina siendo una fórmula muy sofisticada para el fracaso.

Cuando la IA no basta

Antes de hablar de modelos y algoritmos, vale la pena mirar el terreno donde queremos usarlos. En Chile, los grandes problemas sociales no son abstractos: se llaman listas de espera, segregación escolar, inseguridad, brechas territoriales entre otros, y existen mucho antes del hype de la inteligencia artificial.

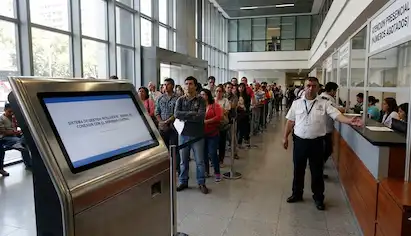

En salud, cerca de 2,7 millones de personas esperan atención. La respuesta suele ser más plataformas, sistemas digitales, “telemedicina inteligente” o módulos de priorización, pero los cuellos de botella siguen siendo: financiamiento, gestión, coordinación, falta de especialistas y mala información para decidir. La tecnología puede cambiar la interfaz, pero no la estructura del problema: si la fila es eterna, digitalizar el número no resuelve la espera.

En educación pasa algo parecido: discutimos el algoritmo del Sistema de Admisión Escolar mientras casi no tocamos un sistema altamente segregado, donde la calidad depende del barrio y del bolsillo. El patrón se repite: problemas complejos, soluciones vistosas. Ponemos el foco en la herramienta y no en el diagnóstico, y cuando el problema está mal formulado, da lo mismo si usamos Excel o el último sistema de IA generativa, es muy probable que fracasemos, solo que ahora con mejor discurso tecnológico y la coartada perfecta de: “así lo definió el sistema”.

No es inteligencia, es optimización estadística

Buena parte de lo que hoy llamamos inteligencia artificial hace algo menos glamoroso (pero muy potente): usa datos para optimizar una función. Puede priorizar qué paciente atender primero, estimar riesgo de deserción, asignar puntajes para beneficios, recomendar dónde patrullar o redactar una respuesta en lenguaje natural. Cambia el contexto, pero la lógica es la misma: tomar o apoyar decisiones a partir de patrones en los datos.

Estos sistemas no piensan ni entienden; automatizan, a gran escala, tareas de clasificación, predicción o generación en función de cómo fueron entrenados. El problema empieza cuando los tratamos como si tuvieran criterio propio y dejamos de mirar dónde está realmente ese criterio.

Las preguntas incómodas siguen siendo humanas:

- ¿Quién eligió los datos?

- ¿Quién definió qué es un “buen resultado”?

- ¿Quién responde cuando un modelo discrimina o profundiza brechas?

- ¿Cómo se audita o se reclama ante una decisión automatizada?

En un país desigual como Chile, olvidar estas preguntas no es un tema técnico: es sobre todo un problema institucional y político.

Automatizando malas preguntas en un país desigual

Cuando juntas problemas mal definidos con herramientas mal entendidas, aparece una combinación peligrosa: empezamos a automatizar malas decisiones.

Si miramos las listas de espera como un problema de software, la solución siempre será: “otra plataforma más”; si en educación todo se vuelve “el algoritmo de admisión”, afinamos fórmulas sin tocar la segregación; si la seguridad se piensa solo como “focalizar con datos”, terminamos patrullando a las mismas personas, en los mismos barrios, con la misma mirada de siempre.

Ahí la etiqueta “IA” se vuelve parte del problema: dejamos de ver estos sistemas como lo que son, aceleradores de la lógica ya instalada. La diferencia con una planilla mal hecha es que ahora las decisiones se despliegan más rápido, más lejos y sobre mucha más gente, con más opacidad y menos espacio para reclamar.

Para la autoridad, además, siempre será más cómodo decir “lo decidió el sistema” que hacerse cargo del criterio que se programó. En un país desigual, esa mezcla significa algo bien concreto: quienes ya estaban en la periferia quedan aún más lejos del centro. No porque la IA “sea mala”, sino porque la usamos sin hacer antes la parte menos glamorosa del trabajo: definir bien el problema y considerar primero a quienes históricamente han estado rezagados.

Dónde la IA sí funciona

Ser críticos con el hype no significa negar que la IA funcione. En biotecnología, descubrimiento de fármacos, diseño de moléculas, energía o logística, distintos modelos de IA y aprendizaje automático han logrado resultados impresionantes.

La clave está en algo muy simple: antes de entrenar el modelo, alguien definió muy bien el problema. Se sabe qué se busca, qué se quiere optimizar, qué es “éxito” y cómo se comprueba en el mundo real. La IA entra como herramienta en procesos que ya tienen método, métricas y responsabilidad clara.

Eso es exactamente lo que suele faltar cuando llevamos esta lógica a la política pública o a problemas sociales complejos. No es que la IA no sirva para el Estado, la educación o la salud; es que, si no hacemos primero el trabajo duro de nombrar bien el problema, ordenar los datos y decidir a quién queremos beneficiar, cualquier sistema “inteligente” puede terminar amplificando desigualdades en lugar de corregirlas.

La pregunta no es si usamos IA o no, sino qué problema queremos resolver, para quién y bajo qué condiciones. Y esa responsabilidad no es de “la tecnología”, sino de quienes toman decisiones. Solo cuando existan diagnósticos sólidos, criterios de justicia y responsabilidades institucionales explícitas, la IA podrá ocupar el lugar que merece: herramientas al servicio de un proyecto de país, y no un simple maquillaje tecnocrático sobre problemas que seguimos sin querer nombrar.

Data Prospectiva SpA

Puerto Varas, Chile